大语言模型(二)- 自然语言处理

一般认为:语言是思想的外壳。我甚至认为,语言还是人格的外壳。🤣

因此,人工智能(AI)的一个重要突破点是一种语言模型就不奇怪了。

旧约中记载,最初的人类只说一种语言(应该不是英语,可能是希伯来语吧😁),因此,牛得很,居然联合起来要造一座通天塔 - 巴别塔,由此,可以登天啊!😄

上帝看不下去了:你们都跑上来了,上面会不会太拥挤,会不会炒高上面的房价啊?于是,上帝出手了:他没有直接跑去毁坏人们的巴别塔,而是让人们说起了不同的语言。这样,人们就没法顺畅沟通并产生了各种隔阂,而造塔计划就泡汤了。

可见,上帝是仁慈的,他没有直接毁坏人们的劳动成果,上帝也是最聪明的,他知道语言的重要性。😆

所以,以ChatGPT为代表的大语言模型AI系统,以语言为核心来解决问题,真是一条接近上帝智慧的奇思妙想啊!\( ̄︶ ̄*\))

要建立语言模型,少不了进行自然语言处理(Natural Language Processing,NLP),即利用计算机对人类的自然语言进行多层次的处理、分析、识别。

其实,在2022年11月30日ChatGPT发布之前,科学技术领域已经对自然语言处理进行了深入的研究。大家也许会记得:李开复博士30多年前的博士工作就是语音识别,这正是自然语音处理的一个重要分支。

ChatGPT的发布距离IEEE(国际电气电子工程师学会)的顶级会刊 - IEEE模式分析与机器智能会刊(IEEE Transactions on Pattern Analysis and Machine Intelligence,创刊于1979年)的创刊也过去了43年!

ChatGPT的发布距离建立英语词汇与语义关系的WordNet(1985年发布第一版,1998年公开发布)公开发布也过去了24年。

更重要的是,人类已经进入了大数据时代很多年,整个互联网上,可以用于训练人工神经网络的人类语料库已经堆积如山。

自然语言处理也深入进行了如下研究并取得了丰硕成果:

语音识别,即语音到文本的过程,我们在微信对话中已经充分领略了其风采。😍

命名实体识别(Named entity recognition,NEM),即将单词或短语识别为有用的实体,例如,将“张三”定义为一个人名,将“广州”定义为一个地点等等。

词性标注,也称为语法标注,即根据特定单词或文本的用法和上下文来确定其词性的过程。

共同引用解析,这是一个识别两个单词或词组是否以及何时引用同一实体的任务。最常见的例子是文章中的“我”和“作者”是指同一个人,而我们用AI绘画时常用提示词“在上一张画的基础上,......”,系统知道“上一张画”是上一次的输出。

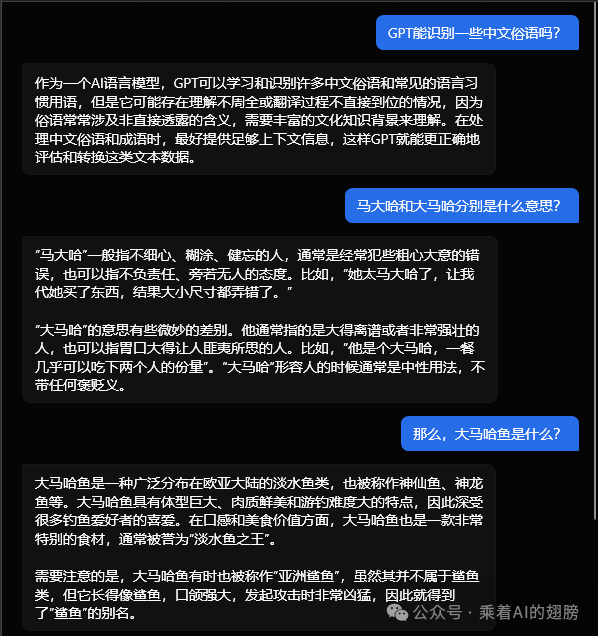

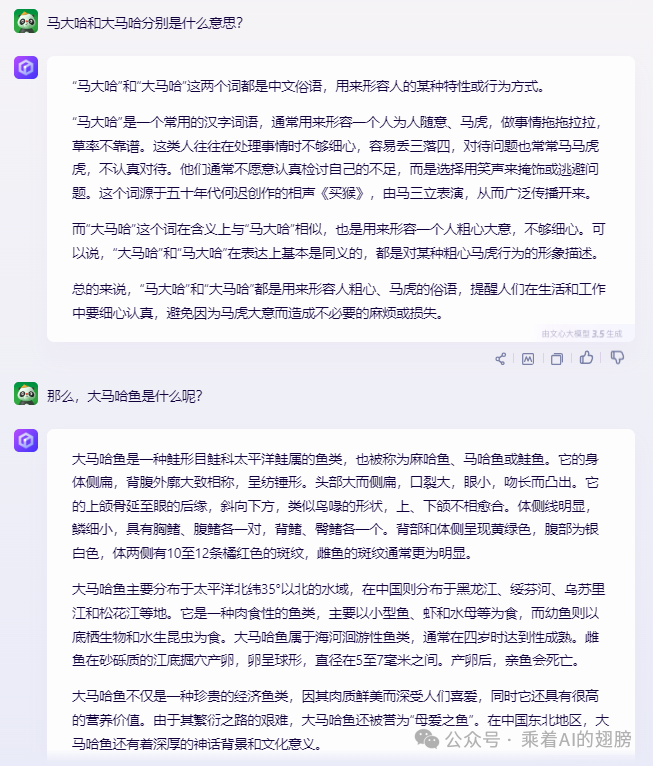

词义消歧,即通过语义分析来选择具有多种含义的单词的意思,从而确定在给定的上下文中各个单词(或者一句话)的意义。例如我们输入错误产生的“词汇”的处理,各种“俗话”或者“术语”的处理,根据上下文来判断词义而不是“按字面意思解释”等。

它们都没有受到字面“马”的影响,而且,当你不说“鱼”时,它们对“大马哈”的解释又有点怪怪的。

这些问题,其实在自然语言处理中都进行了深入研究与开发。

而且,对“大马哈”的奇怪解释,又恰恰源于在LLM中起重要作用的注意力(attention)机制(自注意力)的影响。

情感分析,即从文本中提取主观情感,包括表达者的态度、情感、讽刺、困惑、怀疑等含义。

自然语言生成,即将结构化信息转化为人类语言的过程。这是语音识别的逆过程。

在这些研究、开发中,对后来的大语言模型(GPT类型的各种系统)产生重要影响的有很多。例如上面举例的词义消歧工作。而基础性、重要工作就有:

解码(decoding):将输入的一句话分解为“合适的”基本单元、并将分解的这些单元转换为计算机能够处理的序列(或者称为“向量”,实际上就是一个数组)的过程。

上下文(Context)理解:对语言序列中的上下文进行分析,根据某个周围的单词、短语或句子来解释给定文本的含义。这对于命名实体识别、词性标注、词义消歧和情感分析等任务至关重要。研究人员已经探索了不同的技术,如注意机制、上下文嵌入(如BERT、GPT)和语言模型,以有效地捕获和利用上下文信息。

至此,是不是感到“万事俱备,只欠东风”了?是不是觉得我们已经具备了处理语言(语音)的能力?只需一个工具,就可以将这些林林总总的研究成果化为现实,获得应用呢?

其实,这个工具我们也具备了,因为,上面提到的诸多研究和开发成果已经也被集成到了一些开源的计算机开发工具包中!(为了建设通天塔,需要好多人无私劳动啊😁)

那就是Python的自然语言工具包(Natural Language Toolkit ,NLTK)。Python是一种在计算机网络编程中广泛应用的编程语言,而NLTK则提供了广泛的自然语言处理工具和库,利用这些工具和库,既可进行更为深入的研究,也可进行应用开发。

而且,与NLP发展几乎同步的一系列重要研究也趋于成熟:机器学习和人工神经网络,特别是深度学习算法、具有自注意力的转换器(Transformer)已经获得了巨大成功!

那么,是不是可以把上述各个方面的技术汇在一起实现如上一讲介绍的“输入 - 处理 - 输出”模式的、自动的语言(语言)处理系统呢?

单任务系统的确已经实现,例如,iPhone上的Siri或者电脑或智能手机上的其他各种语言翻译APP,甚至达到了实时翻译的效果。(有没有感到人类又打破了语言障碍,会不会又想着去建立通天的巴别塔呢?😀)

但是,利用这些技术,能够实现令人惊讶的、似乎集成了全人类知识的“超级机器人”吗?显然不是直接利用。其技术方案是怎样的呢?

这就需要大语言模型的核心:多层次具有“自注意力”的转换器(Transformer)和大规模的语料训练上场了。

- 封面图片为荷兰画家(老)彼得·勃鲁盖尔1563年的油画《巴别塔》局部,来自The Tower of Babel by Pieter Bruegel the Elder (arthistoryproject.com)

-文中第一张图片是意大利著名画家、雕塑家和建筑师米开朗基罗1508年~1512年绘制的壁画《创世纪》的局部

-文中第二张图片来源于Pexel - cottonbro-studio

参考文献

[1] IBM, What Is Natural Language Processing? https://www.ibm.com/ topics/natural-language-processing

[2] ChatGPT 3.5: Natural Language Processing (NLP), Decoding and Context, LLM and Transformer

[3] 文心一言: 大语言模型,人工神经网络